최대 864GB 메모리, PRO6000 GPU서버 출시

iwinv가 고속 LLM 프레임워크 vLLM 운용에 최적화된 GPU 가상 서버를 출시했습니다.

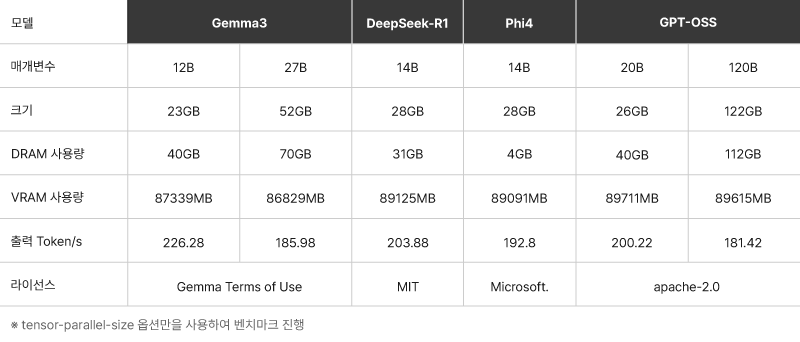

NVIDIA Blackwell 기반 PRO6000 GPU 서버는 최대 864GB 메모리(GDDR7-ECC & DDR5)로

Gemma 3, Phi-4, DeepSeek-R1은 물론 GPT-OSS 120B 규모의 대형 모델까지 안정적으로 운용할 수 있습니다.

vLLM이란?

vLLM은 *Paged Attention 기술을 활용하여 GPU 메모리 내 KV 캐시(Key-Value cache)를 효율적으로 관리하는 오픈소스 프레임워크(LLM 추론 엔진)입니다. 한정된 GPU 자원으로도 응답 속도를 극대화하여 원활한 AI 구동을 지원합니다.

*Paged Attention: LLM 추론 시 KV 캐시를 고정 크기 블록으로 나누어 관리하는 메모리 최적화 기법. 메모리 단편화를 줄이��고 GPU 메모리 효율을 크게 개선함.PRO6000 GPU 서버 강점

GPU 성능 차세대 NVIDIA Blackwell 기반의 PRO6000은 기존 6000Ada 대비 VRAM 용량이 약 2배 증가했습니다.

대용량 메모리 최대 864GB 메모리(GDDR7-ECC & DDR5 기반)를 지원하여 대규모 LLM 운영 환경에서 더욱 안정적입니다.

vLLM 최적화 가상 환경에서도 vLLM 기반의 빠른 토큰 응답을 보장하여 실시간 AI 서비스에 최적화되어 있습니다.

검증된 성능 자체 테스트 결과 GPT-OSS 120B 모델 기준 초당 181.42 Token의 높은 처리 성능을 확인하였습니다

(PRO6000 GPU 1개 기준).

vLLM 벤치마크 결과

GPU 서버가 적합한 워크로드

PRO6000 GPU 서버는 AI 추론 및 학습뿐 아니라, 대규모 연산 처리가 필요한 다양한 환경에 최적화되어 있습니다.

- 대형 언어모델(LLM) 학습 및 서빙

- AI·머신러닝 추론 및 실시간 응답 서비스

- 고성능 데이터 분석 및 시뮬레이션

- 컴퓨터 비전 및 이미지·영상 처리

| 상품명 | GPU | RAM (DRAM + VRAM) | vCPU | Storage(OS) | Traffic | 가격(부가세 별도) |

|---|---|---|---|---|---|---|

| PRO6000.G1 | 1 | 216GB (DRAM 120GB + VRAM 96GB) | 8 | 100GB | 620GB/월 | 55,200원/일, 490,000원/월 |

| PRO6000.G2 | 2 | 432GB (DRAM 240GB + VRAM 192GB) | 16 | 100GB | 620GB/월 | 110,400원/일, 2,980,000원/월 |

| PRO6000.G4 | 4 | 864GB (DRAM 480GB + VRAM 384GB) | 32 | 100GB | 620GB/월 | 220,800원/일, 5,960,000원/월 |

출시 기념 특별 프로모션

GPU 서버 출시를 기념하여 **'반값 프로모션'**을 진행 중입니다.

프로모션 혜택: iwinv의 GPU 서버를 1년 이상 이용한 고객이 추가로 1년 서비스 약정 시, 50% 할인된 금액으로 서비스를 이용할 수 있습니다(위약금 없음!).

신청 방법: iwinv 홈페이지에서 프로모션 상세 내용을 확인하고 즉시 신청 가능합니다

출시 예정: PRO4000, PRO5000 GPU 서버

PRO4000 및 PRO5000 가상 GPU 서버도 순차적으로 출시하여 고성능 LLM 학습·서빙부터 중·소규모 AI 개발까지 폭넓게 지원할 예정입니다. 앞으로도 많은 관심 부탁드립니다! 🙂